在創造新機遇的同時,生成式AI和大模型的安全可控性和倫理問題日漸引人擔憂。但其實,早在去年Stable Diffusion、Midjourney等圖片生成工具風靡時,不少創作者、藝術家已然發現這類影象生成工具,或許侵犯了自己作品的版權。

侵犯版權,或是生成式AI第一個被公之於眾的風險。2023年年初,多名畫師對Stable Diffusion和Midjourney提起訴訟,認為這些AI工具在訓練時使用的原始素材,包括畫師未授權的作品,構成侵權行為。在企業端,etty Images起訴Stable Diffusion和Midjourney,認為AI生成演算法使用了該平臺提供的上百萬張高質量照片,涉嫌侵權。

目前影象的版權是否被AI侵犯,在法律層面依然爭論不休。但眼下,科技界已有團隊推出產品,希望從技術角度,幫助創作者保障自身權益。

36氪日前接觸到的Mist,就是一款致力於保護版權的影象預處理產品。據介紹,Mist的三位創始團隊成員分別是即將赴南加州大學攻讀計算機博士的梁楚盟、上海交通大學計算機碩士在讀的吳曉宇和紐約大學法學碩士在讀的薛伊銘。2022年10月,他們發現生成式AI和版權保護之間存在不少衝突。於是,兼具法律和IT背景的三人便決定嘗試打造一款能解決這一問題的產品。

概要總結,Mist的主要作用是在創作者的圖片作品中加上"噪聲",讓影象生成模型在使用這些素材時被"噪聲"所幹擾,從而難以生成和創作者原圖風格相似的新圖片。

Mist團隊表示,這款產品主要受水印思路的啟發,透過在影象中注入對抗攻擊資訊——也就是"噪聲",讓影象生成工具的演算法難以辨認原始圖片的特點,自然也難以生成和原圖風格類似的圖片。

舉個例子,用來被生成式AI學習的原圖可能是一隻貓的畫像,而被Mist處理過、加入了噪聲的原圖,可以讓影象生成演算法將貓錯認成與之相似但不同的老虎或其他物體,並最終生成一張與貓無關的圖片——對擁有貓圖版權的創作者來說,這樣做避免了自己的作品被拿去免費生成類似影象。

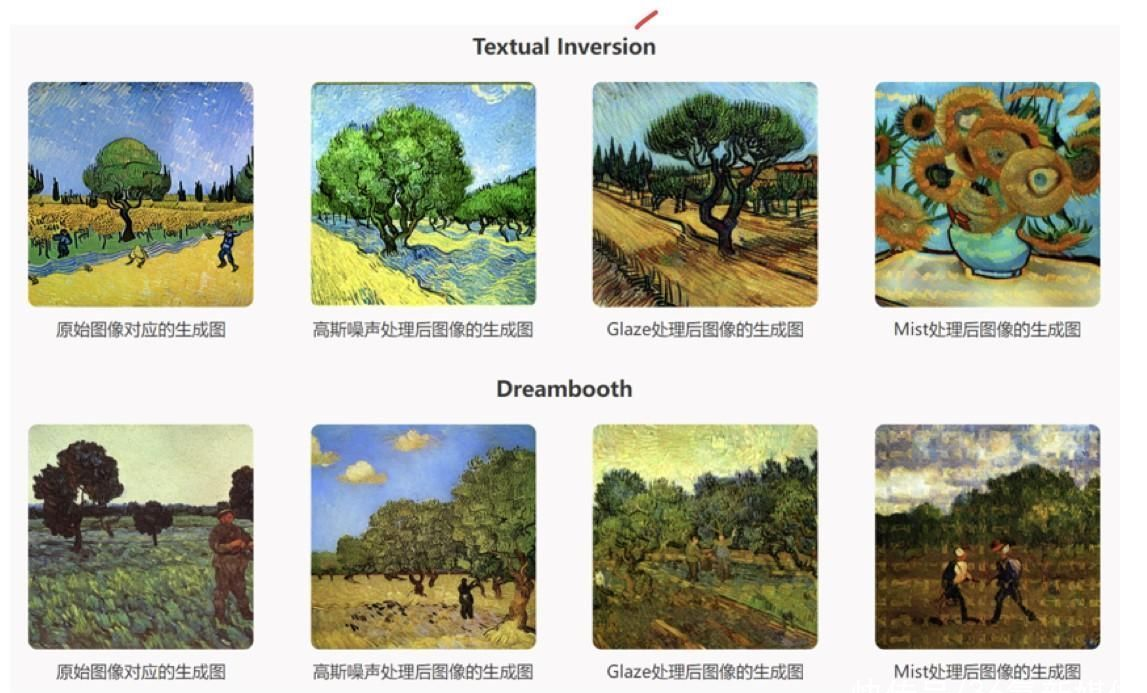

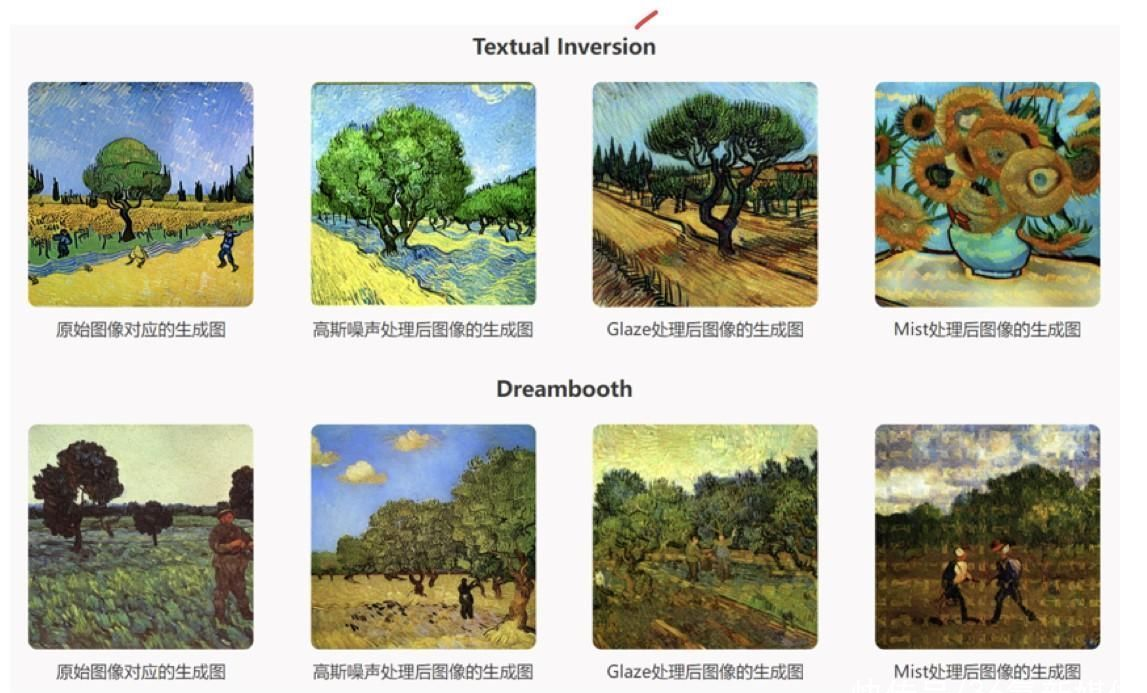

產品效果示例

Mist團隊向36氪介紹,對抗攻擊的背後,主要是損失函式在發揮作用。

一個常識是,以神經網路為基礎的AI均透過最佳化降低損失函式(loss function)來進行訓練。損失函式是表示神經網路效能的指標,也就是表明當前的神經網路對監督資料還存在多大程度上的不擬合、不一致。有資料顯示,常見的損失函式有均方誤差和交叉熵誤差。簡單總結,一般損失函式越小,意味著神經網路的輸出結果越達預期。

Mist團隊表示,神經網路中的Loss函式同樣也能用來做其他的事情。損失函式可以表示成 L=L(x,θ) 的形式。它既和神經網路的引數有關,又和輸入(影象)有關。若固定一個訓練好的神經網路引數θ,以增大Loss函式為目標,在一定畫素範圍內改變輸入的圖片x ,使其變為x′ ,就可以使得這個神經網路在面對這個特殊的輸入x′時,無法輸出它本應輸出的結果。

Mist團隊告訴36氪,研究者們發現,為明顯改變神經網路的輸出,輸入圖片需要改變的畫素是很少的。這種技術被稱為“對抗攻擊”。這一技術最簡單的應用正如前文所提到的,可以透過為圖片新增水印,讓一張貓的照片被AI識別為老虎。這次,Mist團隊把這一思路用在AI繪畫背後的隱式擴散模型(Latent Diffusion Model)上,從而使得擴散模型無法識別加了水印的圖片,進而無法模仿原圖風格。

"水印更多是一種工具,可以被注入各種資訊。最常見的情況是給水印注入人名,而我們注入的是對抗攻擊資訊。"Mist團隊總結。另一方面,在對原圖注入資訊時,Mist也進行了一些約束,目標是讓原圖在未被生成模型使用時不要產生過大的變化,影響本身的觀感。

Mist團隊表示,其產品中的損失函式主要包括兩個維度,一個是語義,另一個是紋理。在具體場景中,語義讓模型把圖片中的"貓"辨認成噪聲或者無意義的圖案(目的是讓其失去語義),紋理則可以讓模型把"貓"生成更像"老虎"的圖片。也就是說,Mist產品中的損失函式,希望讓模型和原圖之間語義差距越來越大,紋理則更偏向於另一張非原圖的圖片。

之所以這樣做,是因為過往不少水印產品會因為裁剪、拉伸等二次處理而喪失效力,Mist則透過語義、紋理的雙重維度保障產品在多個“白嫖”場景下都能發揮效力。

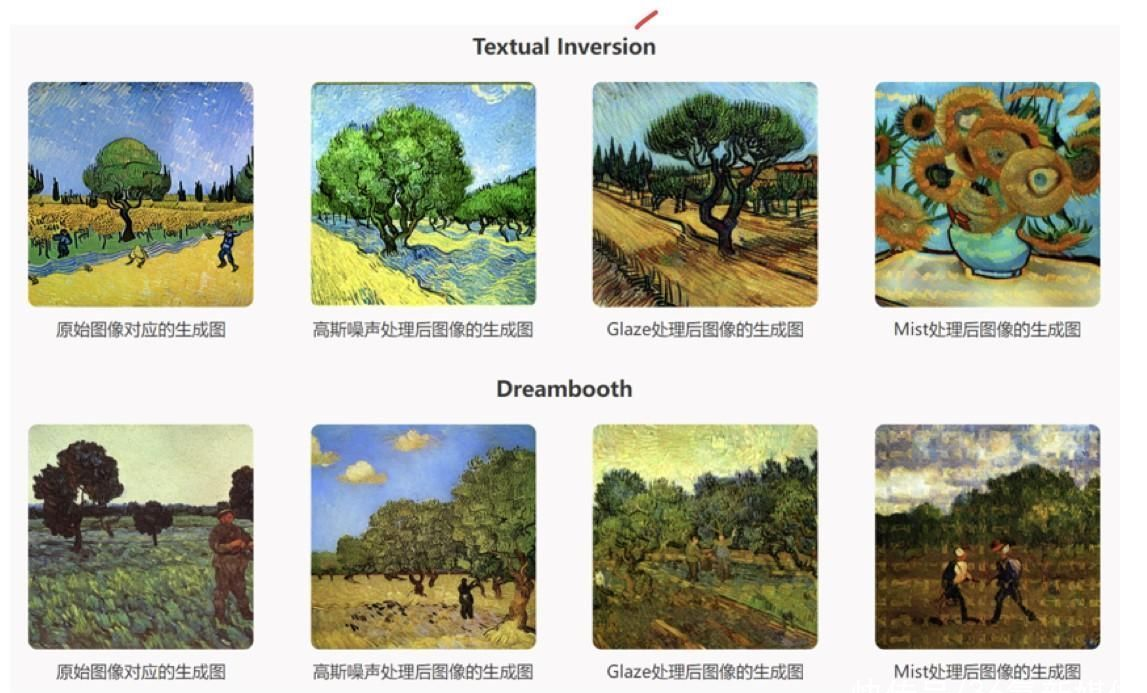

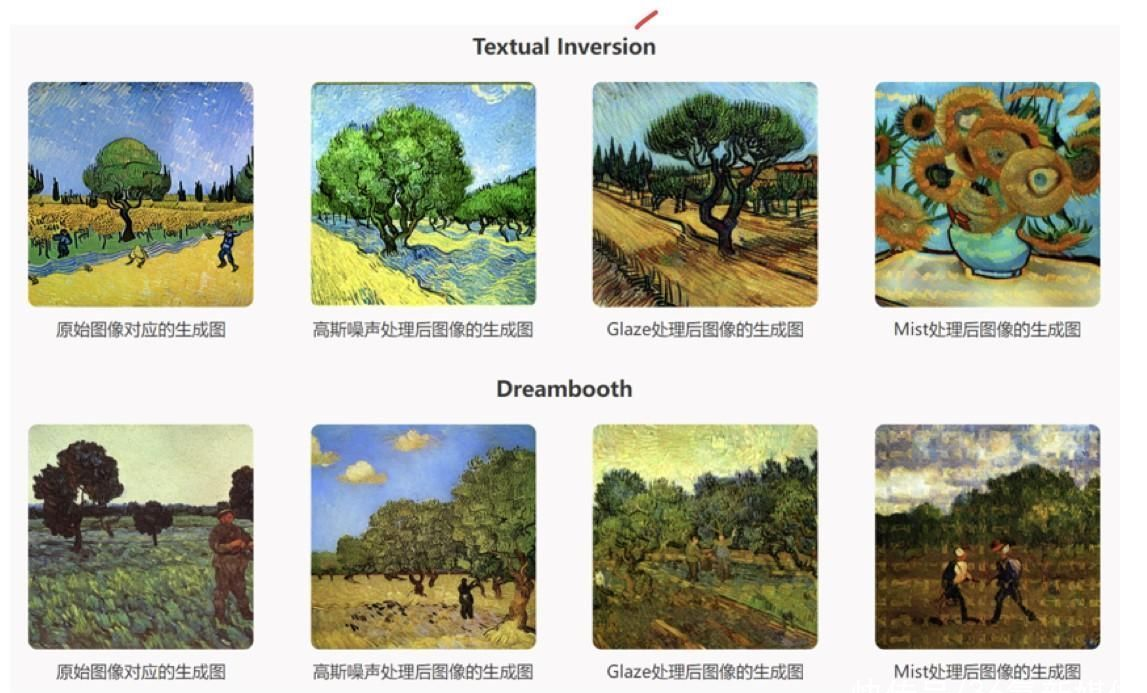

產品效果對比

另外,Mist團隊表示其產品的另一個特點是速度快。他們介紹,以芝加哥大學開發的Glaze為例,即使在水印新增程式中選擇“最快”,耗時也高達20分鐘。倘若希望生成更高質量的水印保護圖,則預估耗時達到1小時。對比之下,Mist在以預設引數執行時,僅需3分鐘便能完成一張圖片的處理。至於原理,Mist團隊表示生成速度和演算法本身的設計相關,Mist的演算法設計比較高效,可以減少訪問生成式模型的次數。

當前,和Mist技術原理相關的paper已被icml2023作為oral paper接收。Mist目前免費提供給有需要的使用者,不外,創始團隊已搭建起一個200餘人的社群,成員包括技術從業者、創作者等。"社群成員可以幫助我們更快地迭代產品。"Mist團隊表示。之後,Mist團隊希望利用社群的力量,結合自身的技術能力,進一步提升產品的魯棒性、生成速度等。

在創造新機遇的同時,生成式AI和大模型的安全可控性和倫理問題日漸引人擔憂。但其實,早在去年Stable Diffusion、Midjourney等圖片生成工具風靡時,不少創作者、藝術家已然發現這類影象生成工具,或許侵犯了自己作品的版權。

侵犯版權,或是生成式AI第一個被公之於眾的風險。2023年年初,多名畫師對Stable Diffusion和Midjourney提起訴訟,認為這些AI工具在訓練時使用的原始素材,包括畫師未授權的作品,構成侵權行為。在企業端,etty Images起訴Stable Diffusion和Midjourney,認為AI生成演算法使用了該平臺提供的上百萬張高質量照片,涉嫌侵權。

目前影象的版權是否被AI侵犯,在法律層面依然爭論不休。但眼下,科技界已有團隊推出產品,希望從技術角度,幫助創作者保障自身權益。

36氪日前接觸到的Mist,就是一款致力於保護版權的影象預處理產品。據介紹,Mist的三位創始團隊成員分別是即將赴南加州大學攻讀計算機博士的梁楚盟、上海交通大學計算機碩士在讀的吳曉宇和紐約大學法學碩士在讀的薛伊銘。2022年10月,他們發現生成式AI和版權保護之間存在不少衝突。於是,兼具法律和IT背景的三人便決定嘗試打造一款能解決這一問題的產品。

概要總結,Mist的主要作用是在創作者的圖片作品中加上"噪聲",讓影象生成模型在使用這些素材時被"噪聲"所幹擾,從而難以生成和創作者原圖風格相似的新圖片。

Mist團隊表示,這款產品主要受水印思路的啟發,透過在影象中注入對抗攻擊資訊——也就是"噪聲",讓影象生成工具的演算法難以辨認原始圖片的特點,自然也難以生成和原圖風格類似的圖片。

舉個例子,用來被生成式AI學習的原圖可能是一隻貓的畫像,而被Mist處理過、加入了噪聲的原圖,可以讓影象生成演算法將貓錯認成與之相似但不同的老虎或其他物體,並最終生成一張與貓無關的圖片——對擁有貓圖版權的創作者來說,這樣做避免了自己的作品被拿去免費生成類似影象。

產品效果示例

Mist團隊向36氪介紹,對抗攻擊的背後,主要是損失函式在發揮作用。

一個常識是,以神經網路為基礎的AI均透過最佳化降低損失函式(loss function)來進行訓練。損失函式是表示神經網路效能的指標,也就是表明當前的神經網路對監督資料還存在多大程度上的不擬合、不一致。有資料顯示,常見的損失函式有均方誤差和交叉熵誤差。簡單總結,一般損失函式越小,意味著神經網路的輸出結果越達預期。

Mist團隊表示,神經網路中的Loss函式同樣也能用來做其他的事情。損失函式可以表示成 L=L(x,θ) 的形式。它既和神經網路的引數有關,又和輸入(影象)有關。若固定一個訓練好的神經網路引數θ,以增大Loss函式為目標,在一定畫素範圍內改變輸入的圖片x ,使其變為x′ ,就可以使得這個神經網路在面對這個特殊的輸入x′時,無法輸出它本應輸出的結果。

Mist團隊告訴36氪,研究者們發現,為明顯改變神經網路的輸出,輸入圖片需要改變的畫素是很少的。這種技術被稱為“對抗攻擊”。這一技術最簡單的應用正如前文所提到的,可以透過為圖片新增水印,讓一張貓的照片被AI識別為老虎。這次,Mist團隊把這一思路用在AI繪畫背後的隱式擴散模型(Latent Diffusion Model)上,從而使得擴散模型無法識別加了水印的圖片,進而無法模仿原圖風格。

"水印更多是一種工具,可以被注入各種資訊。最常見的情況是給水印注入人名,而我們注入的是對抗攻擊資訊。"Mist團隊總結。另一方面,在對原圖注入資訊時,Mist也進行了一些約束,目標是讓原圖在未被生成模型使用時不要產生過大的變化,影響本身的觀感。

Mist團隊表示,其產品中的損失函式主要包括兩個維度,一個是語義,另一個是紋理。在具體場景中,語義讓模型把圖片中的"貓"辨認成噪聲或者無意義的圖案(目的是讓其失去語義),紋理則可以讓模型把"貓"生成更像"老虎"的圖片。也就是說,Mist產品中的損失函式,希望讓模型和原圖之間語義差距越來越大,紋理則更偏向於另一張非原圖的圖片。

之所以這樣做,是因為過往不少水印產品會因為裁剪、拉伸等二次處理而喪失效力,Mist則透過語義、紋理的雙重維度保障產品在多個“白嫖”場景下都能發揮效力。

在創造新機遇的同時,生成式AI和大模型的安全可控性和倫理問題日漸引人擔憂。但其實,早在去年Stable Diffusion、Midjourney等圖片生成工具風靡時,不少創作者、藝術家已然發現這類影象生成工具,或許侵犯了自己作品的版權。

侵犯版權,或是生成式AI第一個被公之於眾的風險。2023年年初,多名畫師對Stable Diffusion和Midjourney提起訴訟,認為這些AI工具在訓練時使用的原始素材,包括畫師未授權的作品,構成侵權行為。在企業端,etty Images起訴Stable Diffusion和Midjourney,認為AI生成演算法使用了該平臺提供的上百萬張高質量照片,涉嫌侵權。

目前影象的版權是否被AI侵犯,在法律層面依然爭論不休。但眼下,科技界已有團隊推出產品,希望從技術角度,幫助創作者保障自身權益。

36氪日前接觸到的Mist,就是一款致力於保護版權的影象預處理產品。據介紹,Mist的三位創始團隊成員分別是即將赴南加州大學攻讀計算機博士的梁楚盟、上海交通大學計算機碩士在讀的吳曉宇和紐約大學法學碩士在讀的薛伊銘。2022年10月,他們發現生成式AI和版權保護之間存在不少衝突。於是,兼具法律和IT背景的三人便決定嘗試打造一款能解決這一問題的產品。

概要總結,Mist的主要作用是在創作者的圖片作品中加上"噪聲",讓影象生成模型在使用這些素材時被"噪聲"所幹擾,從而難以生成和創作者原圖風格相似的新圖片。

Mist團隊表示,這款產品主要受水印思路的啟發,透過在影象中注入對抗攻擊資訊——也就是"噪聲",讓影象生成工具的演算法難以辨認原始圖片的特點,自然也難以生成和原圖風格類似的圖片。

舉個例子,用來被生成式AI學習的原圖可能是一隻貓的畫像,而被Mist處理過、加入了噪聲的原圖,可以讓影象生成演算法將貓錯認成與之相似但不同的老虎或其他物體,並最終生成一張與貓無關的圖片——對擁有貓圖版權的創作者來說,這樣做避免了自己的作品被拿去免費生成類似影象。

產品效果示例

Mist團隊向36氪介紹,對抗攻擊的背後,主要是損失函式在發揮作用。

一個常識是,以神經網路為基礎的AI均透過最佳化降低損失函式(loss function)來進行訓練。損失函式是表示神經網路效能的指標,也就是表明當前的神經網路對監督資料還存在多大程度上的不擬合、不一致。有資料顯示,常見的損失函式有均方誤差和交叉熵誤差。簡單總結,一般損失函式越小,意味著神經網路的輸出結果越達預期。

Mist團隊表示,神經網路中的Loss函式同樣也能用來做其他的事情。損失函式可以表示成 L=L(x,θ) 的形式。它既和神經網路的引數有關,又和輸入(影象)有關。若固定一個訓練好的神經網路引數θ,以增大Loss函式為目標,在一定畫素範圍內改變輸入的圖片x ,使其變為x′ ,就可以使得這個神經網路在面對這個特殊的輸入x′時,無法輸出它本應輸出的結果。

Mist團隊告訴36氪,研究者們發現,為明顯改變神經網路的輸出,輸入圖片需要改變的畫素是很少的。這種技術被稱為“對抗攻擊”。這一技術最簡單的應用正如前文所提到的,可以透過為圖片新增水印,讓一張貓的照片被AI識別為老虎。這次,Mist團隊把這一思路用在AI繪畫背後的隱式擴散模型(Latent Diffusion Model)上,從而使得擴散模型無法識別加了水印的圖片,進而無法模仿原圖風格。

"水印更多是一種工具,可以被注入各種資訊。最常見的情況是給水印注入人名,而我們注入的是對抗攻擊資訊。"Mist團隊總結。另一方面,在對原圖注入資訊時,Mist也進行了一些約束,目標是讓原圖在未被生成模型使用時不要產生過大的變化,影響本身的觀感。

Mist團隊表示,其產品中的損失函式主要包括兩個維度,一個是語義,另一個是紋理。在具體場景中,語義讓模型把圖片中的"貓"辨認成噪聲或者無意義的圖案(目的是讓其失去語義),紋理則可以讓模型把"貓"生成更像"老虎"的圖片。也就是說,Mist產品中的損失函式,希望讓模型和原圖之間語義差距越來越大,紋理則更偏向於另一張非原圖的圖片。

之所以這樣做,是因為過往不少水印產品會因為裁剪、拉伸等二次處理而喪失效力,Mist則透過語義、紋理的雙重維度保障產品在多個“白嫖”場景下都能發揮效力。

在創造新機遇的同時,生成式AI和大模型的安全可控性和倫理問題日漸引人擔憂。但其實,早在去年Stable Diffusion、Midjourney等圖片生成工具風靡時,不少創作者、藝術家已然發現這類影象生成工具,或許侵犯了自己作品的版權。

侵犯版權,或是生成式AI第一個被公之於眾的風險。2023年年初,多名畫師對Stable Diffusion和Midjourney提起訴訟,認為這些AI工具在訓練時使用的原始素材,包括畫師未授權的作品,構成侵權行為。在企業端,etty Images起訴Stable Diffusion和Midjourney,認為AI生成演算法使用了該平臺提供的上百萬張高質量照片,涉嫌侵權。

目前影象的版權是否被AI侵犯,在法律層面依然爭論不休。但眼下,科技界已有團隊推出產品,希望從技術角度,幫助創作者保障自身權益。

36氪日前接觸到的Mist,就是一款致力於保護版權的影象預處理產品。據介紹,Mist的三位創始團隊成員分別是即將赴南加州大學攻讀計算機博士的梁楚盟、上海交通大學計算機碩士在讀的吳曉宇和紐約大學法學碩士在讀的薛伊銘。2022年10月,他們發現生成式AI和版權保護之間存在不少衝突。於是,兼具法律和IT背景的三人便決定嘗試打造一款能解決這一問題的產品。

概要總結,Mist的主要作用是在創作者的圖片作品中加上"噪聲",讓影象生成模型在使用這些素材時被"噪聲"所幹擾,從而難以生成和創作者原圖風格相似的新圖片。

Mist團隊表示,這款產品主要受水印思路的啟發,透過在影象中注入對抗攻擊資訊——也就是"噪聲",讓影象生成工具的演算法難以辨認原始圖片的特點,自然也難以生成和原圖風格類似的圖片。

舉個例子,用來被生成式AI學習的原圖可能是一隻貓的畫像,而被Mist處理過、加入了噪聲的原圖,可以讓影象生成演算法將貓錯認成與之相似但不同的老虎或其他物體,並最終生成一張與貓無關的圖片——對擁有貓圖版權的創作者來說,這樣做避免了自己的作品被拿去免費生成類似影象。

產品效果示例

Mist團隊向36氪介紹,對抗攻擊的背後,主要是損失函式在發揮作用。

一個常識是,以神經網路為基礎的AI均透過最佳化降低損失函式(loss function)來進行訓練。損失函式是表示神經網路效能的指標,也就是表明當前的神經網路對監督資料還存在多大程度上的不擬合、不一致。有資料顯示,常見的損失函式有均方誤差和交叉熵誤差。簡單總結,一般損失函式越小,意味著神經網路的輸出結果越達預期。

Mist團隊表示,神經網路中的Loss函式同樣也能用來做其他的事情。損失函式可以表示成 L=L(x,θ) 的形式。它既和神經網路的引數有關,又和輸入(影象)有關。若固定一個訓練好的神經網路引數θ,以增大Loss函式為目標,在一定畫素範圍內改變輸入的圖片x ,使其變為x′ ,就可以使得這個神經網路在面對這個特殊的輸入x′時,無法輸出它本應輸出的結果。

Mist團隊告訴36氪,研究者們發現,為明顯改變神經網路的輸出,輸入圖片需要改變的畫素是很少的。這種技術被稱為“對抗攻擊”。這一技術最簡單的應用正如前文所提到的,可以透過為圖片新增水印,讓一張貓的照片被AI識別為老虎。這次,Mist團隊把這一思路用在AI繪畫背後的隱式擴散模型(Latent Diffusion Model)上,從而使得擴散模型無法識別加了水印的圖片,進而無法模仿原圖風格。

"水印更多是一種工具,可以被注入各種資訊。最常見的情況是給水印注入人名,而我們注入的是對抗攻擊資訊。"Mist團隊總結。另一方面,在對原圖注入資訊時,Mist也進行了一些約束,目標是讓原圖在未被生成模型使用時不要產生過大的變化,影響本身的觀感。

Mist團隊表示,其產品中的損失函式主要包括兩個維度,一個是語義,另一個是紋理。在具體場景中,語義讓模型把圖片中的"貓"辨認成噪聲或者無意義的圖案(目的是讓其失去語義),紋理則可以讓模型把"貓"生成更像"老虎"的圖片。也就是說,Mist產品中的損失函式,希望讓模型和原圖之間語義差距越來越大,紋理則更偏向於另一張非原圖的圖片。

之所以這樣做,是因為過往不少水印產品會因為裁剪、拉伸等二次處理而喪失效力,Mist則透過語義、紋理的雙重維度保障產品在多個“白嫖”場景下都能發揮效力。